生成式人工智能能够创造和分析图像、文本、音频、视频等内容,越来越多地进入医疗行业,得到大科技公司和初创公司的推动。

Google Cloud,谷歌的云服务和产品部门,正在与匹兹堡非营利医疗公司Highmark Health合作,开发旨在个性化患者接待体验的生成式人工智能工具。亚马逊的AWS部门表示正在与未透露的客户合作,以一种使用生成式人工智能分析医疗数据库的方式来研究“健康的社交决定因素”。微软Azure正在帮助建立一个生成式人工智能系统,用于Providence这家非营利医疗网络,以自动将来自患者的消息分类发送给医护人员。

在医疗领域知名的生成式人工智能初创公司包括Ambience Healthcare,该公司正在为临床人员开发一款生成式人工智能应用程序;Nabla,一款为从业者设计的环境智能助手;以及Abridge,为医学文档创建分析工具。

对于定位医疗行业的生成式人工智能的广泛热情反映在投资方面。迄今为止,医疗领域的生成式人工智能初创公司共筹集了数千万美元的风险投资,绝大多数医疗投资者表示,生成式人工智能明显影响了他们的投资策略。

但是,专业人士和患者对于医疗领域的生成式人工智能是否已经准备好投入使用,观点不一。

生成式人工智能可能不是人们想要的

根据德勤最近的一项调查,仅有约53%的美国消费者表示他们认为生成式人工智能可以改善医疗行业 — 例如,使其更易获得或缩短预约等待时间。不到一半的人表示他们期望生成式人工智能能够使医疗保健更加负担得起。

美国退伍军人事务部下属最大的医疗系统VA Sunshine Healthcare Network的首席人工智能官Andrew Borkowski认为这种怀疑并非没有道理。Borkowski警告称,由于生成式人工智能的“显著”限制以及其有效性方面的担忧,该技术的部署可能过早。

“生成式人工智能的一个关键问题是其无法处理复杂的医疗查询或紧急情况,”他告诉TechCrunch。“它的知识库是有限的 — 即缺乏最新的临床信息 — 缺乏人类专业知识使其无法提供全面的医疗建议或治疗建议。”

几项研究表明这些观点有一定的道理。

在《JAMA Pediatrics》杂志上的一篇论文中,OpenAI的ChatGPT生成式人工智能聊天机器人,在一些医疗机构中有限使用情况下,诊断儿科疾病错误率达83%。在波士顿贝斯以色列医学中心对OpenAI的GPT-4进行诊断助手测试中,医生们观察到该模型近三分之二的情况下,排名第一的诊断结果是错误的。

当前的生成式人工智能在医疗管理员任务方面也存在困难,这些任务是临床医生日常工作中的一部分。在MedAlign基准测试中评估生成式人工智能完成诸如总结患者健康记录和搜索笔记等任务时,GPT-4在35%的情况下失败。

OpenAI和许多其他生成式人工智能供应商警告说,不应依赖其模型来获取医疗建议。但是Borkowski和其他人表示他们还可以做更多。“仅仅依赖生成式人工智能进行医疗可能导致误诊、不当治疗甚至危及生命,”Borkowski表示。

Jan Egger是杜伊斯堡-艾森大学人工智能医学研究所的AI引导疗法负责人,他认为目前在医疗领域安全使用生成式人工智能的唯一方法就是在医生密切监督下进行。

“结果可能完全错误,而且越来越难以意识到这一点,”Egger说。“当然,生成式人工智能可以用于预先编写出院信。但医生有责任检查并作出最终决定。”

生成式人工智能可能强化刻板印象

医疗领域生成式人工智能可能恶化的一种有害方式是强化刻板印象。

在斯坦福医学院2023年的一项研究中,一组研究人员对ChatGPT和其他生成式人工智能驱动的聊天机器人进行了有关肾功能、肺活量和皮肤厚度的问题测试。研究发现,ChatGPT的答案经常是错误的,并且作者发现,其中的答案包括一些长期以来存在的不正确信念,即黑人和白人之间存在生物学上的差异 — 这些不真实的观点已导致医务人员误诊健康问题。

具有讽刺意味的是,最有可能受到医疗领域生成式人工智能歧视的患者也最有可能使用它。

德勤调查显示,缺乏医疗保障的人群 — 主要是有色人种,根据KFF的一项研究 — 更愿意尝试生成式人工智能来寻找医生或心理健康支持。如果人工智能的推荐受到偏见的影响,可能会加剧治疗中的不平等。

然而,一些专家认为在这方面生成式人工智能在改善。

在2023年末发表的微软研究中,研究人员表示他们利用GPT-4在四项挑战性医学基准上达到了90.2%的准确率。普通的GPT-4无法达到这一分数。但研究人员表示,通过提示工程 — 为GPT-4设计提示以产生特定输出 — 可以将该模型的分数提高多达16.2个百分点。(值得注意的是,微软是OpenAI的主要投资者。)

超越聊天机器人

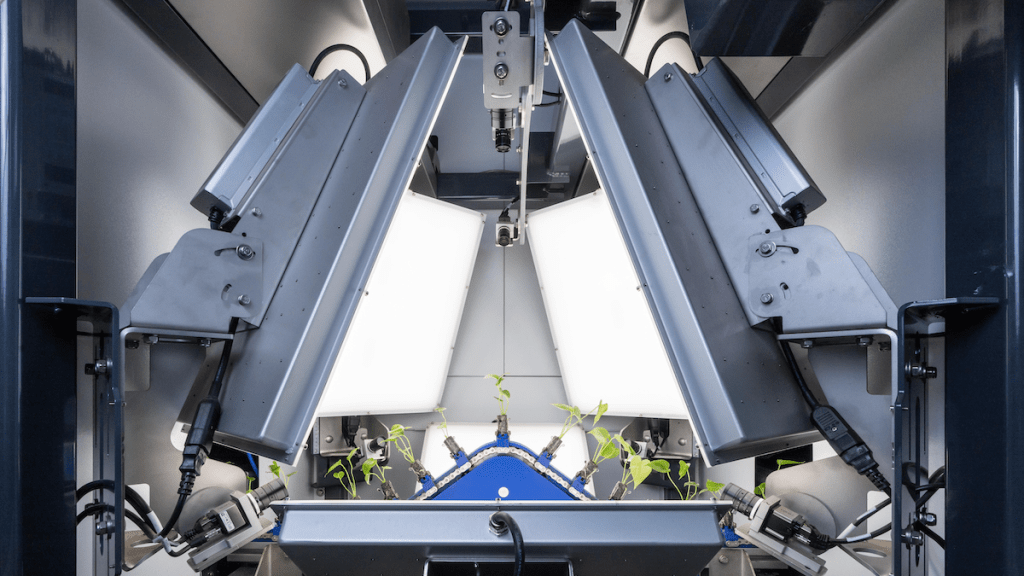

然而,向聊天机器人提问并不是生成式人工智能唯一擅长的事情。一些研究人员表示,医学影像可能会从生成式人工智能的力量中受益良多。

今年7月,一组科学家在《自然》杂志上发表的一项研究中推出了一种称为“临床工作流程推迟的补充驱动系统(CoDoC)”的系统。该系统旨在确定医学影像专家何时应依赖人工智能而不是传统技术进行诊断。根据作者的说法,CoDoC在减少临床工作流程66%的同时表现优于专家。

今年11月,一支中国研究团队展示了“熊猫”(Panda),这是一种用于在X射线中检测潜在胰腺病变的人工智能模型。一项研究显示,熊猫在分类这些病变方面非常准确,这些病变通常会在手术干预太迟时被检测到。

事实上,牛津大学的临床研究员Arun Thirunavukarasu表示,生成式人工智能在医疗领域没有什么独特之处,不会阻碍其在医疗设置中的部署。

“在短期和中期,生成式人工智能技术可以在更平凡的应用方面得到应用,包括文本纠正、自动文档记录和改进搜索功能优化电子患者记录,”他说。“如果技术有效,生成式人工智能技术就可以立即在这些角色中进行部署。”

“严格的科学”

但是,尽管生成式人工智能在特定狭窄领域显示出希望,像Borkowski这样的专家指出,在生成式人工智能能够作为全面辅助医疗工具的有用和可信之前,必须克服技术和合规障碍。

“在医疗领域使用生成式人工智能存在重大隐私和安全顾虑,”Borkowski表示。“医疗数据的敏感性以及滥用或未经授权访问的潜力对患者保密性和对医疗体系的信任构成严重风险。此外,在医疗领域使用生成式人工智能的监管和法律环境仍在不断发展,关于责任、数据保护和非人实体行医的问题仍需解决。”

即使对生成式人工智能在医疗领域持乐观态度如Thirunavukarasu,也指出患者面向工具背后必须有“严格的科学”。

“尤其是在没有直接临床监督的情况下,应该有务实的随机对照试验来证明患者面向生成式人工智能的部署带来的临床益处,”他说。“未来需要建立适当的治理来捕捉大规模部署后可能出现的任何意想不到的伤害。”

最近,世界卫生组织发布了指导方针,倡导对生成式人工智能在医疗领域的科学和人类监督,以及独立第三方对该人工智能的审计、透明性和影响评估的引入。世卫组织在其指导方针中明确指出的目标是鼓励各种人参与生成式人工智能为医疗领域的发展,并有机会在整个过程中提出关注并提供意见。

“在这些担忧得到充分解决并采取适当措施之前,医疗生成式人工智能的广泛实施可能会……对患者和整个医疗行业造成潜在伤害,”Borkowski说。