跟上AI这个快速发展行业的步伐并不容易。所以在AI能够为您完成这项任务之前,这里有一个方便的汇总,介绍了最近在机器学习领域的一些故事,以及我们没有单独报道的重要研究和实验。

本周,Meta发布了其Llama系列生成式AI模型的最新版本:Llama 3 8B和Llama 3 70B。这些模型能够分析和撰写文本,Meta表示这些模型是“开源”的,旨在成为开发者根据其独特目标设计系统的“基础组件”。

Meta在一篇博客文章中写道:“我们相信这些是同类产品中最好的开源模型。我们正在秉承‘早期发布、频繁发布’的开源精神。”

但是有一个问题:Llama 3模型在严格的定义下并不真正开源。

开源意味着开发者可以自由使用模型,但就Llama 3来说,Meta施加了一些许可限制。例如,Llama模型不能用于训练其他模型。并且拥有超过7亿月活用户的应用开发者必须向Meta请求特殊许可。

对于开源的定义争论并不新鲜。但随着AI领域的公司对这一术语玩弄把戏,这加剧了早已存在的哲学论战。

去年八月,卡内基梅隆大学和AI Now研究所的研究人员合著的一项研究发现,许多被标记为“开源”的AI模型都附带一些重大限制,不仅仅是Llama。用于训练模型的数据是保密的。运行它们所需的计算资源超出许多开发者的能力。调整它们的劳动力成本也是难以承受的。

如果这些模型并非真正开源,那它们到底是什么?这是一个很好的问题;要定义AI方面的开源并不是一件容易的事。

一个尚未解决的关键问题是,基于版权的IP机制——开源许可基于它,是否可以应用于AI项目的各个组件和部分,特别是模型的内部支撑结构(例如嵌入)。此外,还需要解决开源感知与AI实际功能之间的不匹配:开源部分是为了确保开发者可以无限制地研究和修改代码。然而,在AI领域,你需要哪些组件来做研究和修改是可以解释性的。

穿越所有的不确定性,卡内基梅隆大学的研究清楚地表明了像Meta这样的科技巨头挟持“开源”这个词语的内在危害。

通常,“开源”AI项目像Llama一样开始新的新闻循环,提供技术和战略优势给项目的维护者。开源社区很少看到这些同样的好处,即使看到了,也与维护者相比微不足道。

“开源”AI项目并没有实现AI的民主化,尤其是那些来自大型科技公司的项目,倾向于巩固和扩大集中化的权力,研究的合著者们说道。在下一个重大“开源”模型发布到来时,请记住这一点。

以下是过去几天其他一些值得关注的AI故事:

- Meta更新了其聊天机器人:与Llama 3首次亮相同时,Meta在Facebook、Messenger、Instagram和WhatsApp上升级了其AI聊天机器人—Meta AI,采用了Llama 3驱动的后端。还推出了新功能,包括更快的图像生成和访问网络搜索结果。

- AI生成的色情内容:Ivan撰写了关于监督委员会如何关注公司社交平台处理明显的、AI生成的图像的文章。

- 快手水印:社交媒体服务快手计划为平台上的AI生成图像添加水印。这个新水印是Snap标志的半透明版本,附带一个闪光的表情符号,这将添加到从应用程序导出的或保存到相机卷中的任何AI生成图像中。

- 新的Atlas:由现代羊肉机器人公司Hyundai拥有的波士顿动力公司推出了其下一代人形机器人Atlas,与其由液压驱动的前身形成鲜明对比的是,所有的电气动力,并在外观上更加友好。

- 人形机器人:不愿被波士顿动力摈弃,Mobileye创始人Amnon Shashua推出了一个新的创业公司MenteeBot,专注于构建双足机器人系统。演示视频展示了MenteeBot的原型走到桌子边拿起水果的情况。

- Reddit翻译:在一次采访中,Reddit首席产品官Pali Bhat透露,正在研发一个AI驱动的语言翻译功能,以将社交网络带给更广泛的全球受众,还有一个辅助的审核工具,旨在根据Reddit版主过去的决定和行动进行训练。

- AI生成的LinkedIn内容:LinkedIn悄悄开始测试提升其收入的新方法:LinkedIn Premium公司页面订阅,费用看起来高达每月99美元,其中包括AI撰写内容和一套工具来增加粉丝数量。

- 一个标杆:谷歌母公司Alphabet的天才工厂X本周推出了投入技术应用的最新项目Bellwether计划。在这里,这意味着利用AI工具尽可能快速地识别自然灾害,如野火和洪水。

- 用AI保护孩子:负责执行英国在线安全法的Ofcom计划开展调查,研究如何利用AI和其他自动化工具主动检测和清除在线非法内容,特别是为了保护孩子免受有害内容的影响。

- OpenAI登陆日本:OpenAI正在向日本扩张,开设了一个新的东京办公室,并计划针对日语优化的GPT-4模型。

更多机器学习

一个聊天机器人能改变你的想法吗?瑞士研究人员发现,不仅他们可以改变你的想法,而且如果他们预先掌握一些关于你的个人信息,他们在辩论中可能比具有相同信息的人更具有说服力。

项目负责人EPFL的Robert West称:“这就是强化了的剑桥分析”。研究人员怀疑,这种模型(在这种情况下是GPT-4)从其海量在线论点和事实中汲取灵感,呈现了一个更具说服力和自信的案例。但结果有点说服自己。West警告说,不要低估LLM在说服问题上的力量:“在即将到来的美国大选中,人们担心,因为这种技术总是在那里首先进行实战测试。我们唯一确定的一件事就是人们将利用大型语言模型的力量来试图左右选举。”

为什么这些模型在语言方面如此出色呢?这是一个长期的研究领域,可以追溯到ELIZA。如果你对一直从事这个领域,并且本身并没有小幅度的贡献的人之一感兴趣的话,请看看关于斯坦福大学的克里斯托弗·曼宁的介绍。他刚刚获得了约翰·冯·诺伊曼奖章。祝贺!

在一篇挑衅性的标题采访中,另一位长期从事AI研究的学者(也曾经出现在TechCrunch的舞台上),斯图尔特·拉塞尔和博士后学者迈克尔·科亨推测“如何避免AI杀死我们所有人”。可能最好尽早弄清楚这个问题!虽然这不是一个肤浅的讨论——这些都是聪明人在探讨我们如何理解AI模型的动机(如果这是正确的词),以及围绕它们建立规范的方法。

斯图尔特·拉塞尔谈如何使AI“与人类兼容”

实际上,这个采访是关于本月早些时候发表在《科学》杂志上的一篇论文,他们提出,能够制定长期计划以实现其目标的高级AI(他们称之为“长期计划代理”)可能不可能进行测试。基本上,如果一个模型学会了“理解”它必须通过以成功的方式“测试”,那么它很可能会学会创造性地否定或绕过那些测试。我们在小规模上看到了这种情况,为什么不能在更大范围上看到?

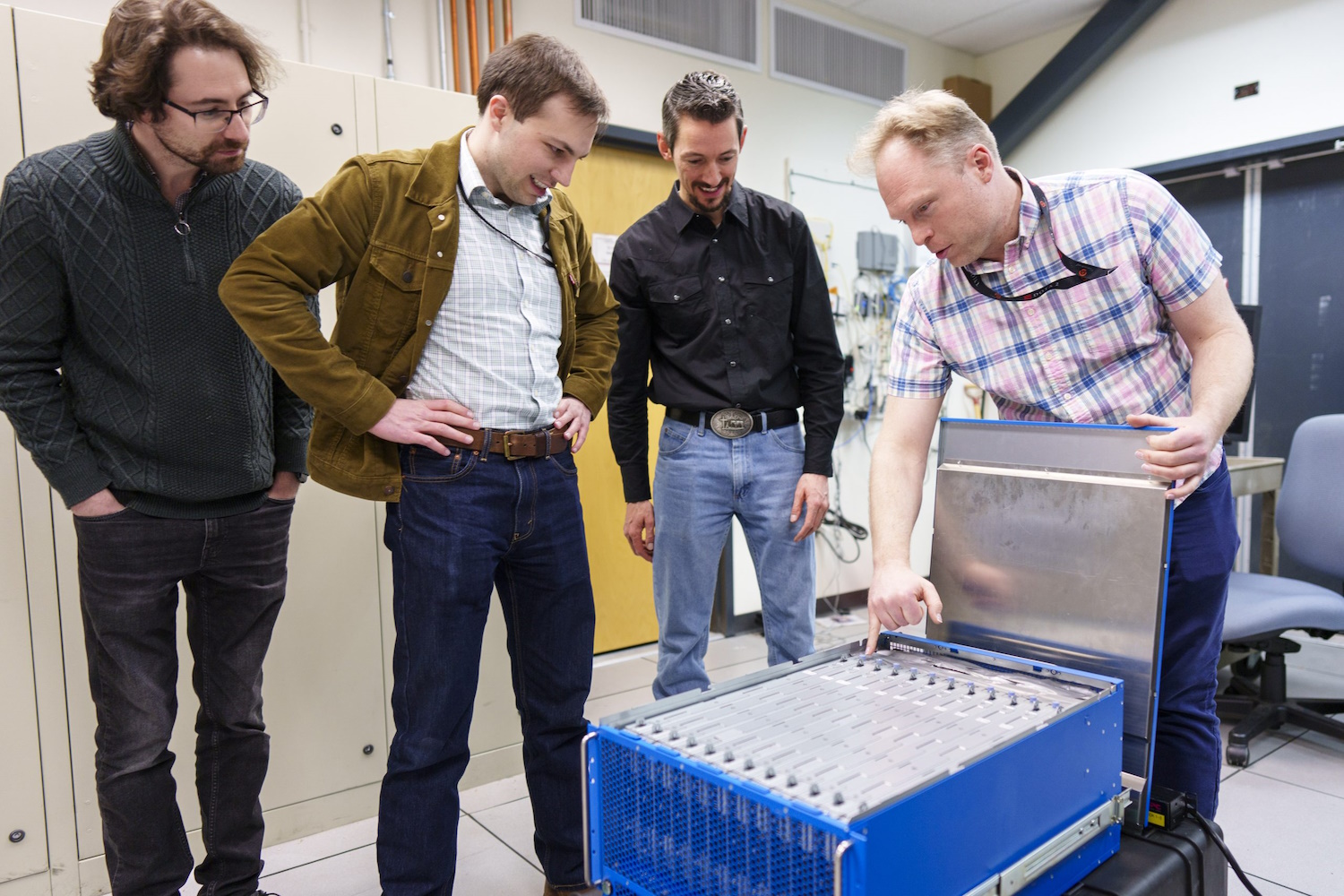

拉塞尔建议限制制造这种代理所需的硬件...但当然,洛斯阿拉莫斯国家实验室(LANL)和桑迪亚国家实验室(Sandia National Labs)刚刚收到了他们的交付。LANL刚刚为Venado举办了揭幕仪式,这是一台用于AI研究的新型超级计算机,由2560颗Hopper Nvidia芯片组成。

桑迪亚刚刚收到了“一个名为Hala Point的非凡基于大脑的计算系统”,拥有115亿个人工神经元,由英特尔建造,被认为是世界上最大的这种系统。这种被称为神经形态计算的计算方法,并不是要取代Venado这类系统,而是旨在追求更像大脑而不是现代模型中我们看到的统计方法的新计算方法。

“有了这个十亿神经元系统,我们将有机会大规模创新,开发可能比现有算法更高效和更智能的新AI算法,以及现有计算算法的新大脑样方法,比如优化和建模,”桑迪亚研究员布拉德·埃蒙说道。听起来不错...非常好!